*こちらは開催報告の詳細版です。概要版はこちらをご覧ください。

*英語版はこちらです。 The English version is here.

| 日時 | 2017年5月24日(水)17:50~19:30 |

| 会場 | ウインクあいち大ホール(人工知能学会全国大会のセッション内) |

| パネリスト | 松尾豊(東京大学)、西田豊明(京都大学)、堀浩一(東京大学)、武田英明(国立情報学研究所)、長谷敏司(SF作家)、塩野誠(株式会社 経営共創基盤)、服部宏充(立命館大学)、山川宏(ドワンゴ)、栗原聡(電気通信大学)、Danit Gal(IEEE、北京大学、精華大学、Tencent) |

| 司会 | 江間有沙(東京大学)、長倉克枝(科学ライター) |

2017年5月24日、2017年度人工知能学会全国大会において、「公開討論:人工知能学会 倫理委員会」を開催しました。一般公開企画として開催し、会場参加者は学会員のほか、約半数が非学会員でした。

人工知能学会倫理委員会は2017年2月に「人工知能学会 倫理指針」を公開しました。一方、海外でも同様に人工知能(AI)と倫理や社会に関するドキュメントが次々と公開されています。例えば、The IEEE Global Initiative for Ethical Considerations in Artificial Intelligence and Autonomous Systemsは2016年12月に「倫理的に調和したデザイン(Ethically Aligned Design)」のバージョン1を公開しました。また、2017年1月、イーロン・マスクらによる非営利団体のFuture of Life Institute (FLI)は、「アシロマAI原則(Asilomar AI Principle)」を公開し、特に自律型兵器(Autonomous Weapons)について議論を進めています。

そこで公開討論では、AIと倫理、社会をめぐる国内外の状況について話題提供したのち、The IEEE Global Initiative for Ethical Considerations in Artificial Intelligence and Autonomous SystemsからDanit Galさんをゲストに迎えてパネルディスカッションを行いました。パネルでは、人工知能学会の「倫理指針」とThe IEEE Global Initiative for Ethical Considerations in Artificial Intelligence and Autonomous Systemsの「倫理的に調和したデザイン(Ethically Aligned Design)」についての議論を行い、今後も連携していく方針を確認しました。

プログラム

●話題提供1 「AIと社会を考える国内外の取り組み紹介」 江間有沙

●話題提供2 「人工知能学会倫理指針の紹介」 松尾豊

●話題提供3 「倫理的に調和したシステム(Ethically Aligned Design)などの紹介」John C. Havens(IEEE) *ビデオメッセージ

●話題提供4 「アシロマAI原則(Asilomar AI Principles)などの紹介」Richard Mallah (FLI) *ビデオメッセージ

●パネルディスカッション

詳細レポート

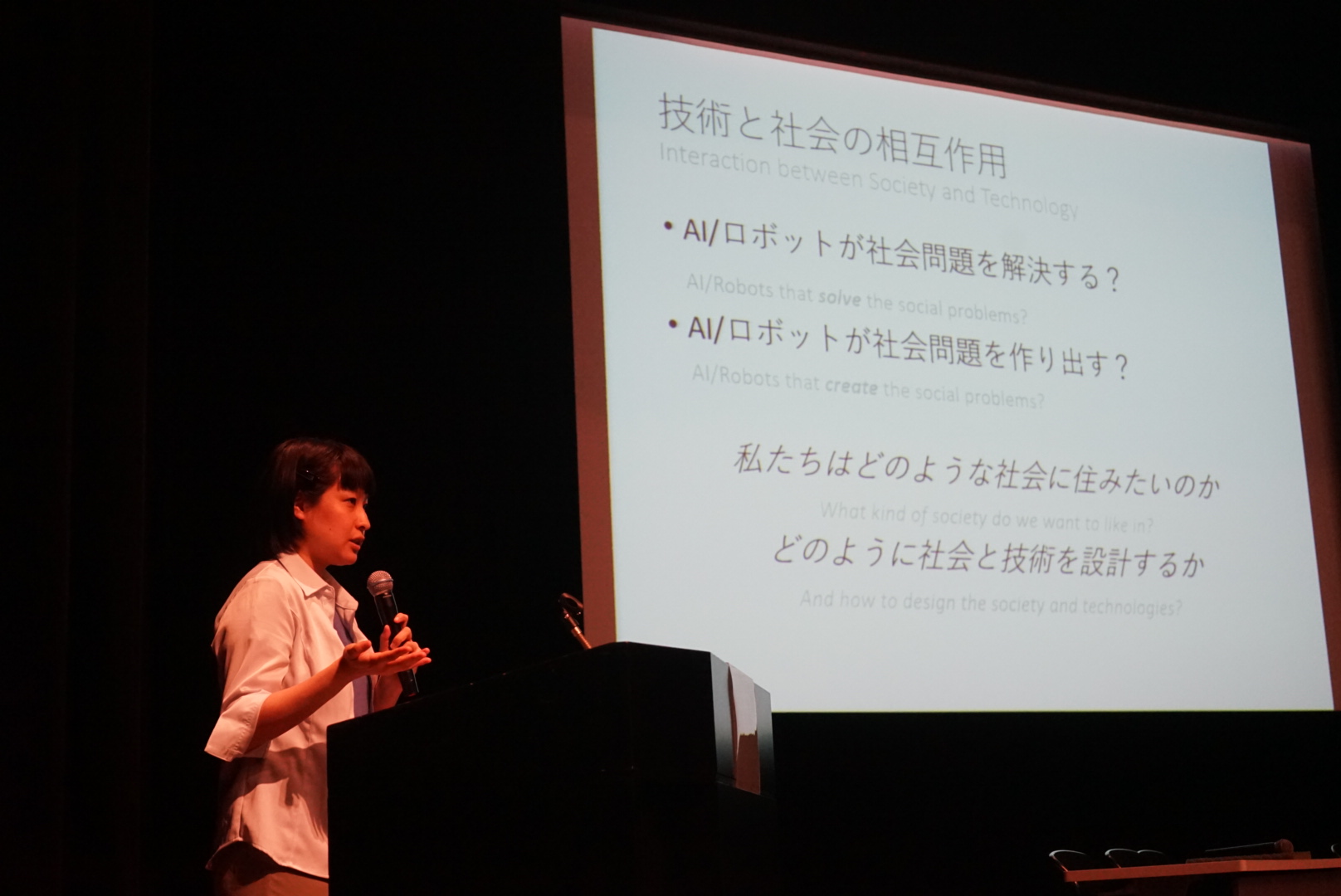

話題提供1 「AIと社会を考える国内外の取り組み紹介」 江間有沙

基本的な考え方として、技術と社会は相互作用をしています。AIやロボットは、「社会問題の解決につながる」という論点があります。一方で、AIやロボットが「新たな社会問題を作り出す」という懸念もあります。これは両方正しいものです。技術と社会は相互作用をしている。そこで、私たちはどういう社会に住みたいのか、どういう社会をデザインしていくのかを、今から考えていかなければならないというのが共通認識だと思います。

ではどのように考えていけばよいのか。「AIと倫理」と言ったときにどんな倫理があるのか、ざっくり3分類してみました。ひとつは、研究者倫理です。これは、「研究者の社会的責任」や「不正行為」といったもので、人工知能のみならずあらゆる研究に当てはまるものです。

「AIと倫理」はさらに2つに分けられます。ひとつがAI Ethics(AIの倫理)です。AIをどう開発するべきか、といった原則やガバナンスのルール作りですね。さらに、AIの開発が社会にどうインパクトを与えるかといった議論もAI Ethicsに含まれます。これらは、技術者、政策決定者や経済学者、社会学者、倫理学者といったいろんな人たちが議論しています。

一方で、Ethical AI(倫理的なAI)という考え方もあります。これは、倫理的に、道徳的に振る舞うAIを指しますが、これを構築することで権利や自律とは何かや、人間と機械の関係とは何かを改めて問うアプローチです。

この分類は、脳神経倫理学での分類を参照しています。脳神経倫理学でも、脳神経科学の倫理、倫理的な脳神経科学という分類があります。

次に、AIと社会、倫理についてのドキュメントを紹介します。ここに示すのは、この半年間で出されたドキュメントの一部です。国内外で政府、アカデミア、NPOなどの組織、個人などいろいろなところが、AIと社会や倫理についてのドキュメントを出しています。

いくつか具体的に見ていきましょう。これは、総務省のAIネットワーク化推進会議が議論をしているものです。研究者に対するAI開発ガイドラインと、運用や利用者に対するユースケースシナリオが議論されています。

内閣府の「人工知能と社会に関する懇談会」も2017年3月に最終報告書を出しました。これは一般の人のAIへの不安に対して応えようとしたもので、論点別、分野別にそれぞれまとめています。

一方、海外ではThe Future of Life Institute(FLI)が2017年1月に「アシロマAI原則(Asilomar AI Principle)」を出しました。これは、すでに様々なところで公開されていた報告書や原則を集めてまとめ、議論をして23項目に絞り込んだものです。

また、本日ゲストに来ていただいているDanit GalさんのいるThe IEEE Global Initiative for Ethical Considerations in Artificial Intelligence and Autonomous Systemsが2016年12月に「倫理的に調和したデザイン(Ethically Aligned Design)」のバージョン1を出しました。これは138ページにわたる大作で、8項目の論点が出ています。今年の秋にバージョンを改定するため、世界中からフィードバックを受け付けていました。

また、人工知能学会は2017年2月に9項目からなる「倫理指針」を公開しました。こちらは、9項目目に「人工知能への倫理順守の要請」があるのが特徴的で、後程、松尾委員長から説明があります。

それぞれのドキュメントを先程の3分類で整理してみましょう。

人工知能学会倫理委員会の「倫理指針」は、主に研究の責任や心構えといった研究(者)倫理に焦点があります。基本的な行動規範をアカデミアや技術者に考えてほしいというものです。一方で、総務省は研究者に対する開発原則と運用・利用者への影響を分けて整理しています。内閣府は「一般の人への不安」への対応が強いためAI倫理の中でもその社会的影響について書かれた文書となっています。FLIやIEEEは幅広くAI倫理を扱っており、内容も技術者に対するものから助成機関や法律家等多様なステイクホルダーに対するものなどが混在しています。また、汎用人工知能など倫理的なAIについても言及しているのが特徴的です。

この表の下の方へ行くに従って、技術者だけでなく、他の分野の人たちと一緒に議論をしていくことが必要になります。

実際、どのドキュメントでも、協力とコミュニケーションが重要であり、分野横断的、国際的に考えていく必要があります。また、現在だけではく、未来についても同様です。人間だけではなく、機械や環境とのインタラクションについて考える必要もあります。

その中で、人工知能学会 倫理委員会の役割は何かを、これから議論していければと思います。

話題提供2 「人工知能学会倫理指針の紹介」 松尾豊

まず経緯から説明します。2014年に倫理委員会ができました。当時からAIに関する世の中の注目が高くなってきたということで、松原(仁)前会長のもとに、倫理委員会が設置されました。

最初は、「AIの倫理とは一体何か」を何度も議論してきましたが、なかなか話がまとまらない。AIとは何か、という合意すら難しい。そこで、ひとまずベースとなる研究者倫理を定めていこうという方針になりました。

昨年の全国大会で、倫理指針の前の倫理綱領案を示させていただいて、議論をしました。その後昨年12月に改訂版を作り編集委員会、理事会等からコメントをもらい、それをふまえて改定したものが、今年2月に理事会で承認されて、学会として倫理指針を公開しました。

倫理指針の内容は、ごくごく当たり前のことを書いています。序文にはこうあります。

人工知能研究は、人間のような知性を持ち自律的に学習し行動する人工知能の実現を目指している。人工知能が、産業、医療、教育、文化、経済、政治、行政など幅広い領域で人間社会に深く浸透することで、人々の生活が格段に豊かになることが期待される一方で、悪用や濫用で公共の利益を損なう可能性も否定できない。(中略)人工知能研究者は、人工知能が人間社会にとって有益なものとなるようにするために最大限の努力をし、自らの良心と良識に従って倫理的に行動しなければならない。

社会全体からは「研究者は何を考えているのかわからない。怖いものを作っているのではないか」という見られ方をすることもありますが、我々はそうではない、人類社会のことを考え誠実に行動しようとしている、という最低限のことを表明しようとしたのがここの意図です。

内容は、第1条の人類の貢献から始まり、法規制の遵守、他者のプライバシーの尊重、公正性、安全性、誠実な振る舞い、社会に対する責任と続きます。それから第8条では社会との対話、自己研鑽しながら対話をしていきましょうとあります。

第9条は、さきほど江間さんの分類で「倫理的なAI」というところに入っていましたが、「人工知能が社会の構成員またはそれに準じるものとなるためには、上に定めた人工知能学会員と同等に倫理指針を遵守できなければならない。」としています。これは現状想定するものではないが仮に高いレベルのAIを作った時には、それは倫理指針を遵守しなければならない、またそれがAI作った場合はまた倫理指針を遵守しなければならない、という再帰的なものになっています。

話題提供3 「倫理的に調和したシステム(Ethically Aligned Design)などの紹介」John C. Havens(IEEE) *ビデオメッセージ

John C. Havens, Executive Director, IEEE Global Initiative for Ethical

Considerations in Artificial Intelligence and Autonomous Systems

http://www.johnchavens.com/

話題提供4 「アシロマAI原則(Asilomar AI Principles)などの紹介」Richard Mallah (FLI) *ビデオメッセージ

Richard Mallah, Director of AI Projects, Future of Life Institute

https://futureoflife.org/author/richard/

パネルディスカッション

江間 まず、人工知能学会が作成した倫理指針について、Danit さんからコメントをお願いします。

Danit みなさん、こんにちは。私はIEEEのアウトリーチ委員会の活動の一環として、AIと倫理について世界中で取り組んでいます。日本はこの分野でとても進んでいるので、特に日本でAIの開発者の人と話すことができるのはとても嬉しく思っています。実際、日本のAIに関する規制は世界で最も進んでいます。仕事柄色んな国の規制を見る機会がありますが、未来のAI規制の政策決定を考える時に、日本にものに立ち戻って考えることがよくあります。

人工知能学会の倫理指針は非常に独特で優れたものです。これについてまず3つ良い点をコメントします。続いて3点、今後こうした方がいいのではという点を申し上げます。

まずひとつめは、研究者、開発者と技術自体を同じ高い水準に保とうとしていることが優れています。これは当たり前と思われがちですが、実は革命的なことです。これは倫理的なAIの開発にあたり、重要な鍵となります。

倫理委員会は世間と関わっていくだけでなく、そこから真剣に学ぶことを強調しているところが、他の組織と比べてユニークなところです。この中で、謙虚さやポジティブなアプローチに触れていますが、これは実は今AIの研究者や開発者に欠けている部分なんですね。だからここをしっかりすることで、社会や生活を大きく変える技術の設計を建設的に進めていけるでしょう。

そして倫理指針は倫理的な行動の規範であるだけでなく、開発者や研究者のためのロバストなコミュニティを構築して、それ以外の多くの人にも扉を開くものとなります。こうした包摂的な精神こそが有益なAI開発に不可欠な要素なのです。

ですが、第9条で疑問を感じます。技術自身が人間と同じ基準を遵守するとありますが、これはどういうことでしょうか?人間を真似する形でAIを開発することは良いことなのでしょうか?悪いことなのでしょうか?というのも、人間の知能について解明されていないことも多い中で、こういった人工知能を開発するというのはどういうことなのでしょうか。私たち自身がわかっていないをどうして作ることができるのでしょうか。

これが2つ目の疑問につながります。この規準がダブルスタンダードになる可能性があります。AIについて期待をしすぎているのではないでしょうか?AIに人間と同じように振る舞うこと、反応することを期待していないでしょうか?私たち自身が作成したデータ、アルゴリズムやシステムを作って、AIの下す決定にどのようにして責任を追わせることができるのでしょうか。

3つ目のポイントは、AIをどのように扱っていくのかということです。人間と同等で社会の一員として扱うのか、召使のように扱うものなのか、それとも超人類的な決定ができる人間より優れたものとして扱うべきなのか。この倫理指針は日本の政策決定にも重要に働くでしょう。日本政府はSociety5.0というコンセプトを打ち出しています。その中ではAIを人間社会に取り込もうというものもありますが、そうしていく前に、まず何をAIに対して期待をするのか、十分に議論する必要があります。

江間 Danitさんありがとうございます。倫理指針について、事前にGoogleフォームで意見募集をしました。そのコメントを紹介します。要点は主に3つあります。

倫理指針に対するコメント

・デュアルユース等の議論が入っていない(難しいだろうが)

・倫理委員会は表紙問題から入ったというのがあるが、表現の自由について整理してほしい

・現在のAIと未来のAIを混同していないか

・条項の順番はどういう基準で決まっているのか

指針の出し方や倫理委員会について

・法の研究者や倫理の専門家も入れて議論をするべきではないか(IEEEの方は色々な人が入っている)

・社会だけではなく学会員との対話をして欲しい

今後について

・より具体的なQ&Aを別途記載することはできないか

・第8条に社会との対話とあるが、具体的にどのような活動を今後していくのか

・倫理委員会の目的やモチベーションは何か

長倉 今、会場からもGoogleフォームにコメントを頂いていて、いくつか紹介します。

・倫理委員会では軍事の議論はしてこなかったのか

・倫理指針は学会員の研究活動について制約をもたらすものなのか

・難解すぎる、8項目は多い

松尾 Danitさんのコメントに答えます。第9条について、日本のAIが海外のAIと異なる点として、日本文化に起因するものが挙げられます。日本文化には、鉄腕アトムや八百万の神といった、AIとロボットが共生するイメージが昔からあります。産業用ロボットの人口当たりの導入数は世界一です。ロボットに対する社会の抵抗感が低いのです。これは日本を世界から見た時の特異な点だと思います。

その点から、第9条は、仮にAIを人間と同じように見るなら、そのAIも倫理指針を守って下さいというものです。ただ、多くの人が「そんなことできるの?」「これは何だ?」と思うと思います。そこが重要で、「AIが人間社会で認められるとはどういうことなのか?」「AIが倫理指針を守ることはできるのか?」という疑問を誘発する効果を狙っています。そう疑問を持つことで、技術に興味を持ったり、倫理とは何かを考えるようになったりして欲しい、というのが第9条を入れた意図です。また、ご指摘のように、未来のAIと現在のAIが混在していますが、まずは技術の現状についてわかってほしいという意図があります。

西田 第9条については私もプッシュしましたが、もっとプラクティカルな理由もあります。AIが高次の機能を扱うようになってくると、例えば、人の命にかかわるような自動運転、トレーディングで財産に直接関わりあるような判断とAIが自動的に行うようになります。そうすると、何らかAIを理解し、人に負の影響を与えるAIを防ぐようにしたいと考えます。ただ、今の社会で培われてきた社会的、法などでの私たちの知恵は、人間同士に対するものです。そこで、社会的または法人的な意味でAIを位置づけることは意味があることだと思っています。

長谷 (第9条について)AIと人間の間で線引きをする時に、人間よりも倫理的なものは今のところ設定できないという、わかりやすい理由もあると考えています。AIが人間よりも倫理的になった場合、あるいは人間の認知能力の決定的なエラーが研究によって明らかになり、これをAIが回避できる場合など、第9条を書き換える可能性があると思っています。

堀 AIが人間とイコールか、優れているか、劣っているかというDanitさんのコメントがありましたが、そこについて私たちはこうだという主張をしません。それを決めるのは、世の中全般の合意事項であるべきです。例えば、(人間と同じように)社会の構成員になりうるAIが作られるとしたら、どういうことを考えるべきか?という問いがここでは書かれていると考えています。

Danitさんのコメントの中で「ダブルスタンダード」とありましたが、それは何を意味しているかもう少し説明いただけませんか?

Danit 私たち人間は機械をある特定の形で作るときに、合理性とモラルをもち、理解可能で決定を下せるような、人と同様な責任を持つものを作ることを期待します。しかし、機械はそのように責任を持つものはまだできていません。それをダブルスタンダードと呼んでいます。つまり、この指針ではAIを社会の構成員とするとするのであれば、機械に義務と責任をも与えるということを意味しなければならなりません。それをこの指針はそのことを考えていないのではないか、ということです。

長倉 コメントで、倫理指針による研究への制約がないかどうかという質問がありましたが、どうでしょうか?

松尾 もちろん制約を課すものではありません。人工知能学会は自由なところです。制約をするものではないと考えています。ただ、社会の中で、何をやって良くて何をやってはいけないかという議論をする必要があります。(倫理指針を遵守することが)ひるがえって自分の研究によって社会によい影響を起こるようになるといいと思っています。

武田 去年の全国大会で示した「倫理綱領案」と、承認された倫理指針では語尾が少し変わりました。倫理綱領案では、「〜すべき」としていたところを、理事会での議論の中で、「〜に努める」としました。大きな違いは、義務にならないように扱われている点です。努める、心がける、ということで、いわゆる制約にはなっていないことを示しています。ただ、これはポジティブな意味での「制約」と理解して欲しい。規制する意味での「制約」ではありません。

西田 「制約」の解釈だが、制度としての制約と、心の中での制約では、レベルが異なります。倫理指針を作った思いとしては、論文を書く、ビジネスになるということだけを考えて研究者が研究をするのはよくないのではないかというのがあります。ただちに規制につながるものではないと思っていますが、ただ何の制約もなくてガイドラインとなるのも少し違うとも思っています。

江間 では次の話題で、IEEEでつくった「倫理的に調和したデザイン(Ethically Aligned Design)」について、指定討論者の塩野さんからコメントをお願いします。

塩野 Danitさんにお伺いします。拘束力(binding force)についての話題ですが、「倫理的に調和したデザイン(Ethically Aligned Design)」に拘束力はありますか?ガイドラインは、AI開発において現実的な側面も持たないといけないと私は考えています。喫緊の課題として、自律型兵器システム(Autonomous Weapon Systems, AWS)や致死的自律型兵器システム(Lethal Autonomous Weapon Systems, LAWS)と呼ばれる自律的なAIを搭載した兵器が開発されつつある現状で、これらの規制が必要ではないかと議論されています。ただ、日本ではこれらの議論がまだ皆無に等しい状態です。海外ではこれらはどういった状況にありますか?

Danit “Ethically Aligned Design”の拘束力は、短い答えとしてはNO、長い答えとしてはYESと言えます。”Ethically Aligned Design”はAIの問題点やIEEEからの推奨を包括的にリスト化したもので、世界的に受け入れつつあるベストプラクティスをまとめたもので拘束力はないものです。そうはいっても、IEEEでは標準化を担っていて、この標準化が技術の規準となります。標準化によって明確な拘束力を持つこともあるでしょう。

自律型兵器システム(AWS)については、皆が心配をしています。ただ現実的にはすでに開発されており、実際に使用されています。私はイスラエル出身で、兵役義務で自律型兵器システム(AWS)開発に関わったことがあります。開発の禁止を呼び掛けるのは簡単ですが、国によっては開発禁止となっても独自に開発を進めるでしょう。

塩野 こうした兵器や軍事の話は倫理問題では避けることができませんが、そもそも研究者がそこまで考えるべきなのでしょうか?

Danit これを考えることはエンジニアにとって重い負担になります。その意味では、関わるべきではないと言いたいのですが、同時に関わるべきだと思います。

技術自体は、悪い意味でも良い意味でも中立なものです。自律型システムは致死的になることもあるし、防御となることもあります。自動運転車と同じ話です。なので、エンジニアが開発を行う際には、技術の悪用の可能性があるということを念頭に置きながら、意図を持って研究に取り組むべきだと思います。この点は人工知能学会の倫理指針にもしっかりと記載されていますね。

逆に、エンジニアの方にお伺いしますが、技術を作れるからといって、実際にそのような技術を作るべきなのでしょうか?

山川 私は全脳アーキテクチャ・イニシアティブというNPOの代表として、脳全体のアーキテクチャ上での汎用人工知能(Artificial General Intelligence、AGI)のオープンな協創開発を促進し、最初期のAGIを人類と調和させることを目指しています。ここで強調される、汎用性は、経験を通じて様々な能力を獲得できる知能です。AIの萌芽期から期待されつつも未完成な知能の側面はいくつかありますが、汎用性は実践的でかつ順序付け可能な評価指標となりうるため、AI技術者により検討されてきています。

AIの汎用化は実は段階的に進んでおり、その影響は時と共に増大し、基本的には良くも悪くも現状の特化型AIで起こっている変化が徐々に拡大するようなものです。つまり汎用性のみに起因するネガティブな影響を強調する必要性は少ないです。

一方で「自律性」もまた現状のAIで未完成な知的機能です。ただしここで扱う自律性は、実用的な意味です。 例えば上司の指示に対して自ら考えて行動する部下といった意味での自律性です。自律的な部下のほうが優秀だが、上司が言わないこともやるので危険も伴う。一方で(赤子のように手足を動かすような)剥き出しの自律性だけでは役に立たないのも明らかで、安全かつ有意義に世界を探索し理解するには、前提として知能が汎用性を高めておく必要があります。また自律性はAI自身の価値観によって駆動されており、多くの高等動物において概ね強化学習という仕組みによって備えられています。子供がいつしかお金の価値を理解するように、「手段を目的化する」機能を強化学習は実現している、つまり所与の主目標から副目標を導き出せます。

こうして、価値システムを変化させる高度に自律性の高いAIは、元々の主目標が、外部の人間よって設計されたとしても、環境との相互作用を通じてあらたな目標や意図を造り出していきます。AIを制御するためには逸脱を検知して反応するキルスイッチのようなものを様々なレベルで設定してくことが対策となります。その際に、AIが作り出した危険な副目標や意図を検知することも重要になるでしょう。さらに危険な副目標や意図が生成される事自体を抑制するような技術開発も重要となります。そうなると9条にあるようにAIに人間と似た倫理観を如何にもたせるかという問題に立ち返るでしょう。

何れにしても現状としてAIが大きな経済的利潤を生み出し、それが再投資されるサイクルが存在すること、さらに実効的にAI開発を規制することは困難と思えます。それゆえAI専門家から見ればAI開発それ自体を止めることはほぼ不可能で、開発が進む前提の中で人類に利益をもたらしリスクを減らす技術を提供してゆくべきだと思います。

栗原 AIを語るときによく「強いAI」「弱いAI」と言いますが、そうではなくてAIが道具なのか、自律なのかで考えると構図がすっきりすると思います。現状、AIは道具です。

自律にもレベルがあって、AIがどういう判断をできるかを人間が設計しています。このレベルが低い設定なら問題ありませんが、例えば「ご主人様が快適になるようにする」といったように設定のレベルが上がったときに、自律的なAIは何をするのでしょうか。また、AI自身が目的を見つけていくとなったときに、僕ら人間はこれまで扱ったことがない機械と初めて向き合うことになると思います。そうなったときに「自律ってこういうことなんだ」と僕らが考える時が来ます。その時に僕らは試されることになると思います。

つまり道具としてのAIは使う側の人がよく使うか悪く使うかが問題ですが、自律型のAIでは悪用された時の影響はより大きくなります。悪用されないようにどうするかは、僕らが考えないといけない。ただ、技術を作れるのなら、僕らエンジニアは作らないとは言えません。作るならある程度ちゃんとやらないといけません。

服部 技術的にできることをやるかやらないかという質問ですが、技術的にできるならやる、と答えざるを得ません。技術は中立だとか、デュアルユースだとか言われます。負の側面はありますが、それでもエンジニアは自分がやっていることが社会を良くして信じているとやまない人が多いはずです。技術的にできることならやり、それをよりよく使う方法を考えたいと思っています。

武田 技術的に可能なものは作ります。そうして作るものは、ニュートラルかもしくはより良くするものだと自分では考えていますが、栗原さんの意見は多分言い訳で、作ったもので実際に良くなるかどうかはわかりません。もちろん良くなったらいいね、と思って作るのですが。

(倫理指針は)制約にならないと言いましたが、もし制約を作るとしたら、何か新しい技術を作った時に研究のアウトプットによって「こういった社会影響がある、もしかしたらこういうネガティブな側面もあるかもしれない」というリスクを、作った研究者が洗い出して評価をしてもらう、というものが次世代のAI研究には必要になるのかもしれないと思いました。

堀 さきほどの塩野さんの質問はちょっと乱暴で、軍事について関わるかかかわらないかというのは、個人として、コミュニティとして、学会として、日本全体としてといった、段階によって区別して議論をすることが必要だと思います。

個人的には、軍事に関連する研究を僕は決してやりません。ただ、あらゆる技術は軍事応用の可能性があります。将棋のプログラムだって、軍事戦略をたてるのに使えます。デュアルユースの議論がなされていますが、私たちが開発する技術はすべてデュアルになりうると考えます。より良い方向向かって私たちが作ったにもかかわらず、ネガティブに使われうることに対して、私たちができることは、謙虚に正しい情報を提供することではないでしょうか。悪用について考えずに開発をするのではなく、悪用されることが想像できるなら、可能な限りの想像力を働かせて、悪用されないようにする、そうした誠実な態度を持つことが、学会として言えることではないでしょうか。

西田 さっきの自律性の議論に戻りますが、自律性=悪というのは短絡的過ぎます。今のAIが道具だというのも危険です。確かに短期的にはAIは道具でしかありませんが、長期的には人間のパートナーに近くなります。

私はAIの自律性への期待を持っています。「人間+道具としてのAI」だと倫理的に間違ったことをするかもしれませんが、「人間+自律的なAI」によって倫理的に良い方向に行く可能性に私は賭けたいと思っています。

Danit AIがパートナーになった時には、権利と義務が生じます。我々は表現の自由、意志決定の自由をAIに与えるのでしょうか?

西田 AIがパートナーになった時に、表現の自由は与えるべきだと考えます。最終的には人間の判断をするのかどうかはわかりませんが、AIが言いたいことを言えるのは重要で、AIの方が良いことを言ってくれる可能性があるのではないでしょうか。

長谷 第9条に書いてあるように、AIが社会の構成員またはそれに準じるものになるためには、AIが責任を果たすためのコミュニケーション能力を持つ必要があります。そうしないと、社会の中で人間と同等の権利を持たせるのは不可能だと思います。コミュニケーションをとれない、説明責任をとれないAIが社会の構成員になるのは厳しいと思います。

長倉 議論も尽きないと思うのですが、最後に松尾さん、まとめをお願いいたします。

松尾 人工知能学会の倫理指針をJohnさん、Richardさん、Danitさんが褒めてくれたのがすごく嬉しかったです。倫理指針を出すまでは本当に大変で、まとまらないし、文句を言われるし、理事会でいったん否決されるし。でも、修正をして苦労をしたところを評価いただいて、本当によかったと思います。

倫理指針を出したというのは始まりにすぎなくて、技術的に何がポイントになるのか、そもそも倫理とはどういう概念から構成されていて我々は何を気にかけるべきか、といった議論をできればと思っていました。今日、いろいろなフィードバックをいただいて、次に進んで良いのだと思いました。今後は、安全保障やAIの自律性といった踏み込んだ議論をしていけたらと思っています。

懇親会で、Danit氏と松尾氏