*この投稿は、2016年度人工知能学会全国大会「公開討論:人工知能学会 倫理委員会」(2016/6/6)での江間有沙氏の発表をまとめたものです。

公開討論で倫理綱領について議論する材料として、人工知能と社会に関する研究や政策を、10分ほどで簡単にご紹介させていただきます。

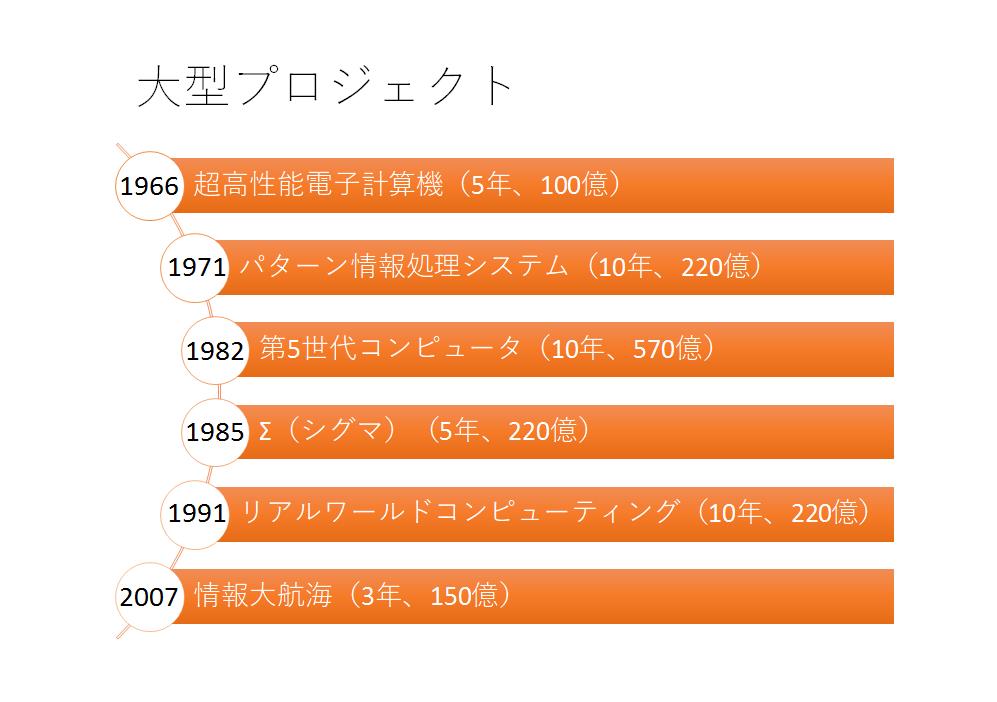

現在、人工知能の第3次ブームで、人工知能開発に10年で1000億円を投じるといわれていますが、1980年代にも大型プロジェクトが展開されていました。皆さまの中にも、これらのプロジェクトを懐かしく思われる方がいらっしゃるかもしれません。

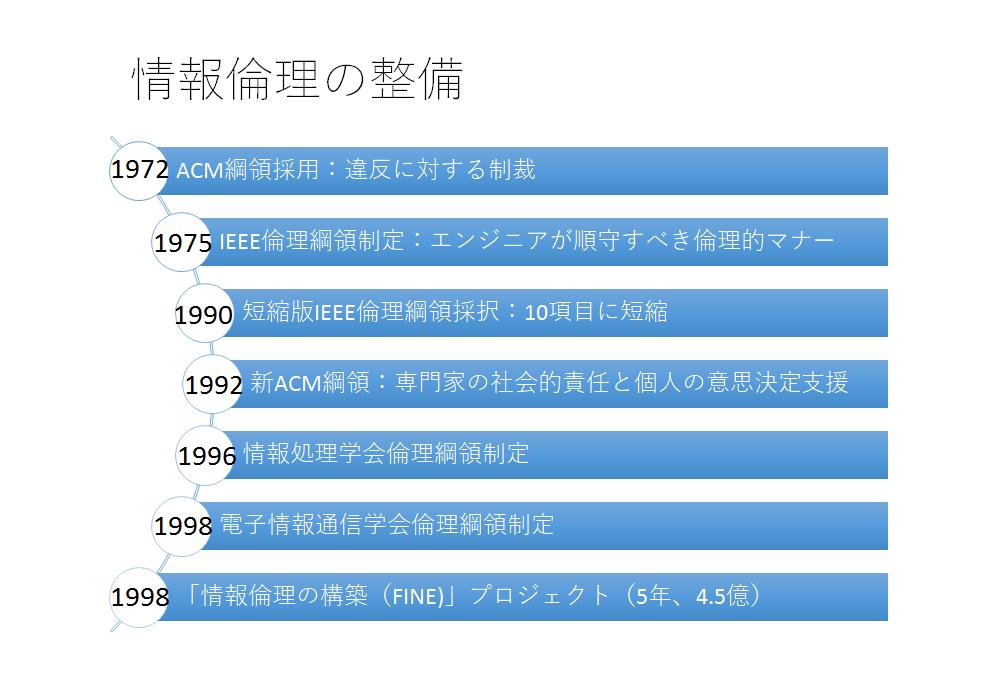

しかし、その裏で、情報倫理の議論も行われていたことは、ご存知でしょうか。

ACMは1972年に綱領を作りましたが、これは「してはならないこと」を列挙したものでした。これに対し1992年の新綱領(ACM Code of Ethics and Professional Conduct)は、社会に対して専門家としての責任を示し、公衆に対して貢献すること、また倫理的なジレンマに陥ったときにどうすればよいかの基礎的な原理を定め、事例集も作られました。

IEEEも1974年に独自の倫理綱領を作成し、1990年には10項目の短縮版(IEEE Code of Ethics)が作成されました。公共の福祉との整合性、利益相反の回避などが盛り込まれており、その後も改定を重ね、現在も広く認知されています。

なお、ACMとIEEEの合同タスクフォースが「ソフトウェア工学倫理・専門職実践綱領(Software Engineering Code of Ethics and Professional Practice)」を作成し、公共性や製品など8つの領域に対する倫理の原則が規定されています。

日本でも96年に情報処理学会が、98年に電子情報通信学会がACMやIEEEを参考として倫理綱領を制定しました。これらの綱領も時代に沿って改正が行われています。

また98年には「情報倫理の構築(FINE)」プロジェクトが発足し、京都・広島・千葉大学で研究が推進されました。

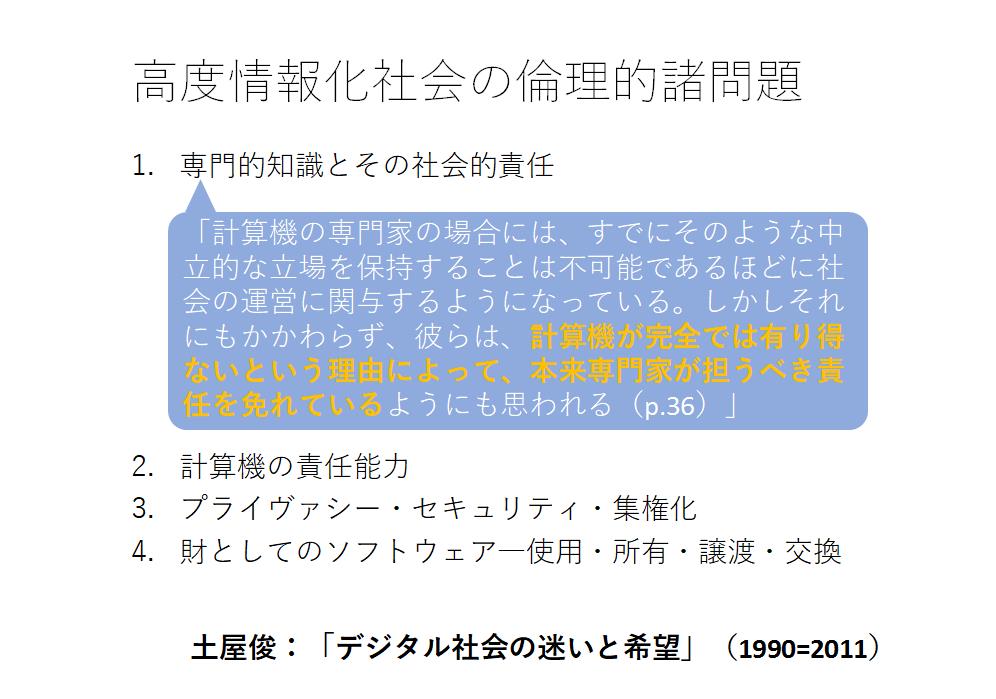

さてそこで90年代当時どのような情報倫理の議論がされていたか、本日ゲストとしてご登壇いただいております土屋俊先生の著作を参照に紹介したいと思います。

こちらにあげられている項目は、90年代に書かれたものとも思えないほど、現在も中心的課題であるものばかりです。20年以上たった今でも、なぜ我々は議論をしているのか。それは、技術と社会が相互作用しているからです。技術や社会が変われば問題は変化する。我々は常にその時代や文脈の最適解を考えていかなければならないとも言えます。

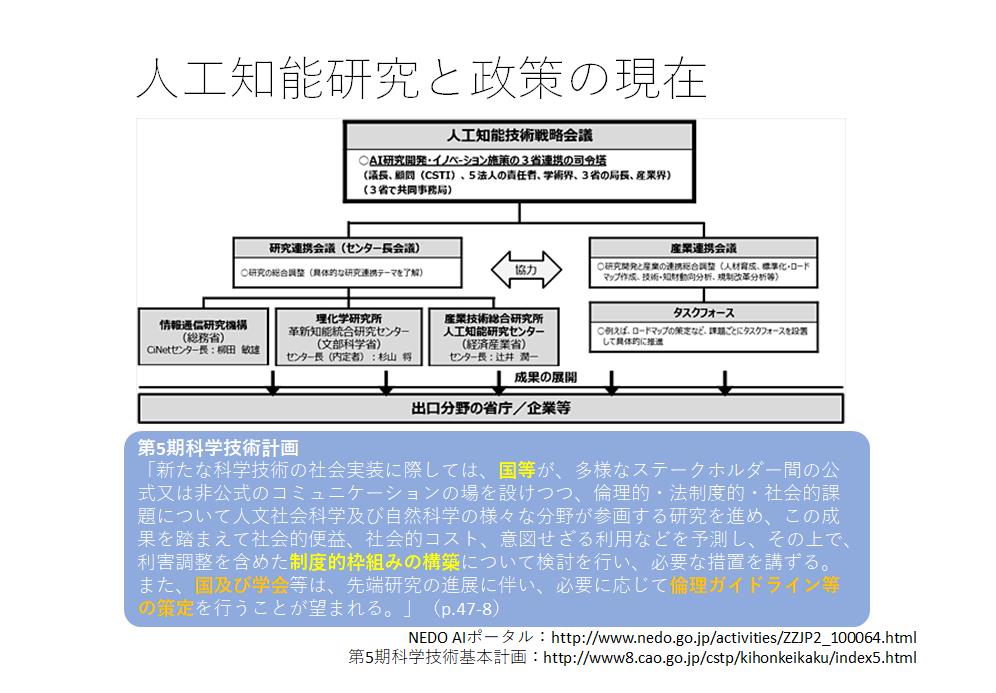

現在、第5期科学技術基本計画などのもとで人工知能研究が推進されています。

通産省時代のプロジェクトと異なるのは、制度や倫理などについても同時に考えていくことが必須となっていることです。国は制度的枠組み構築の検討、また学会などには倫理ガイドラインの策定が望まれています。

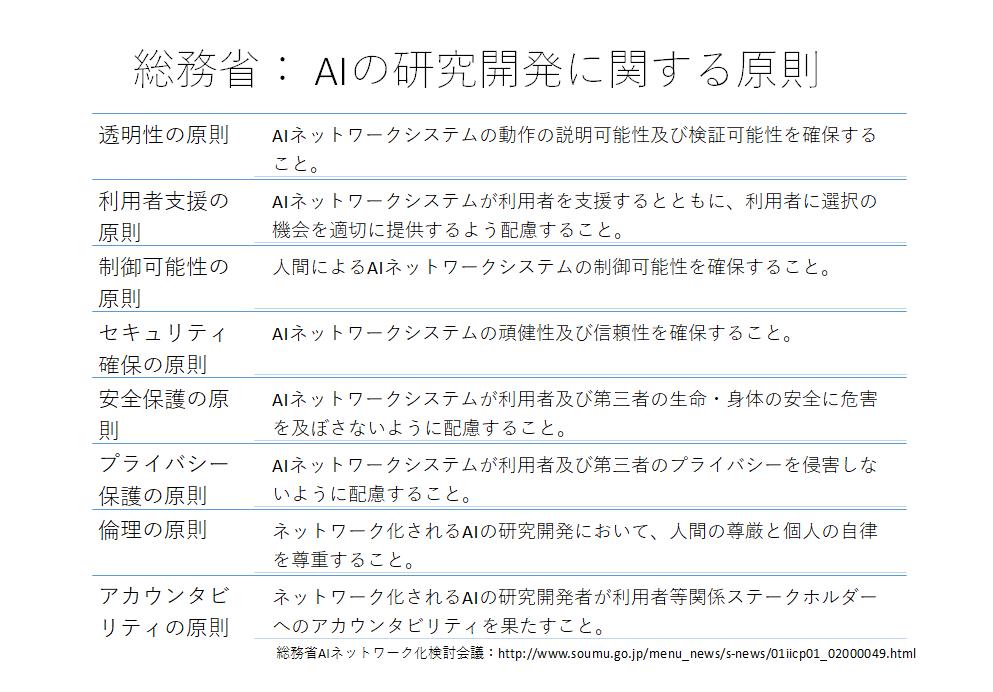

例えば、総務省のAIネットワーク化検討会議は2016年5月に人工知能の研究開発に関する原則を発表しました。これはG7香川・高松情報通信大臣会合で提案されたほか、OECDデジタル経済に関する閣僚級会合でも提案される予定です。このように、現在国際的な開発原則策定の動きがあります。

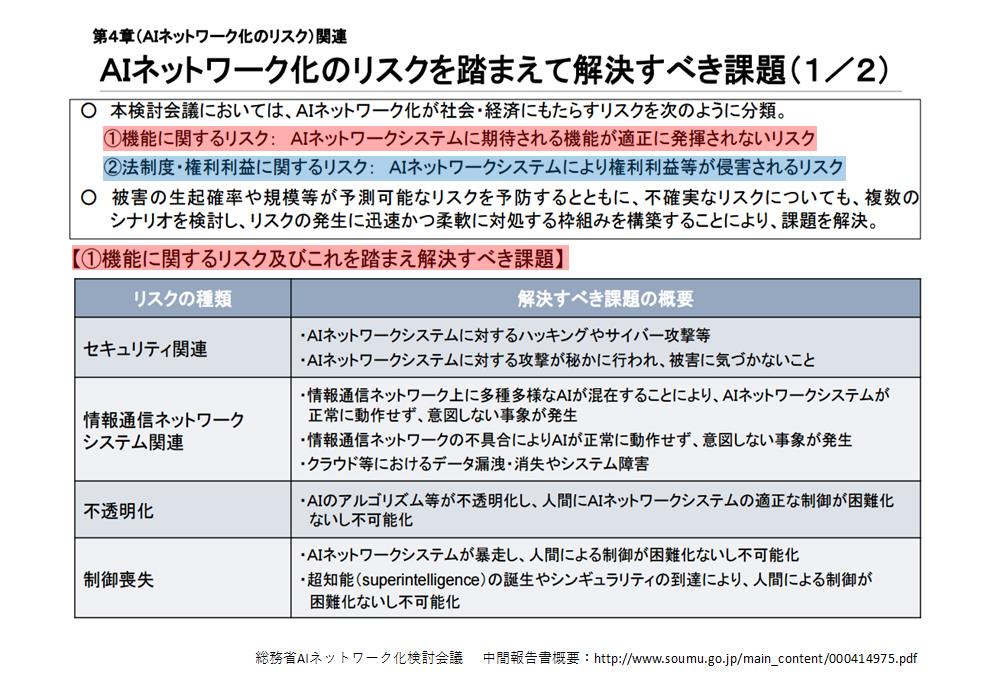

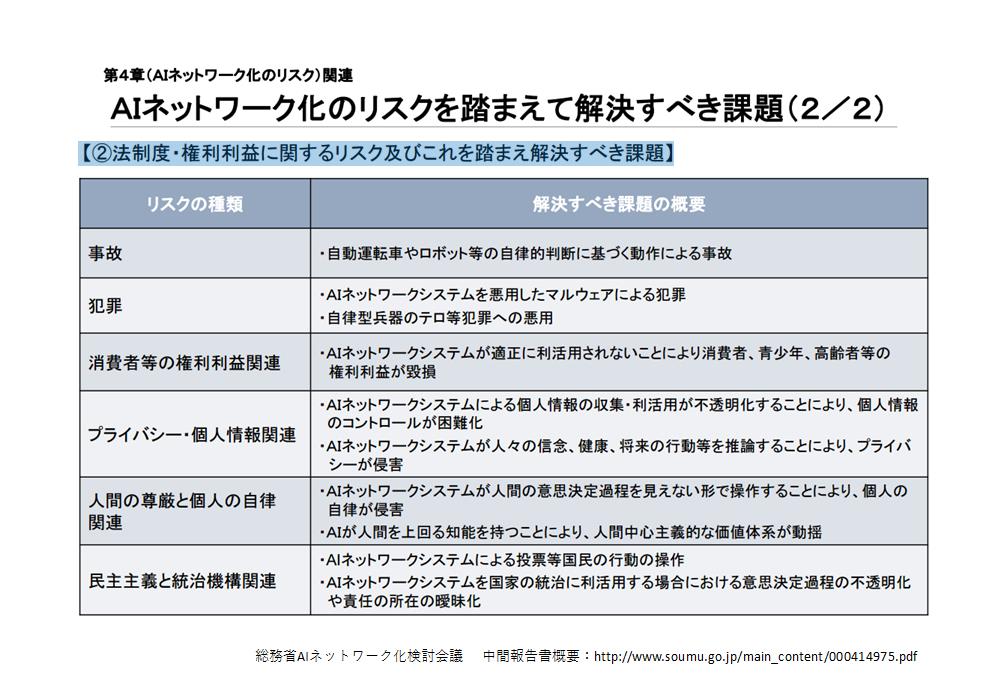

この検討会議では、解決すべき課題などのリストも挙げられています。

一方、研究者コミュニティとしては倫理綱領を制定する以外に、どのようなことができるのか。例として2つご紹介します。

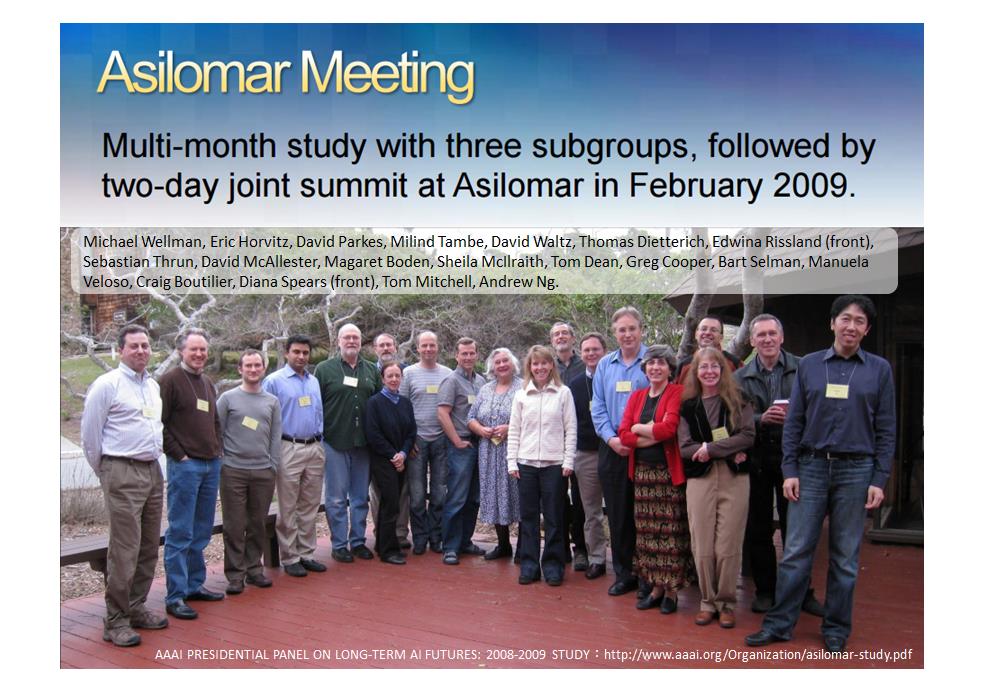

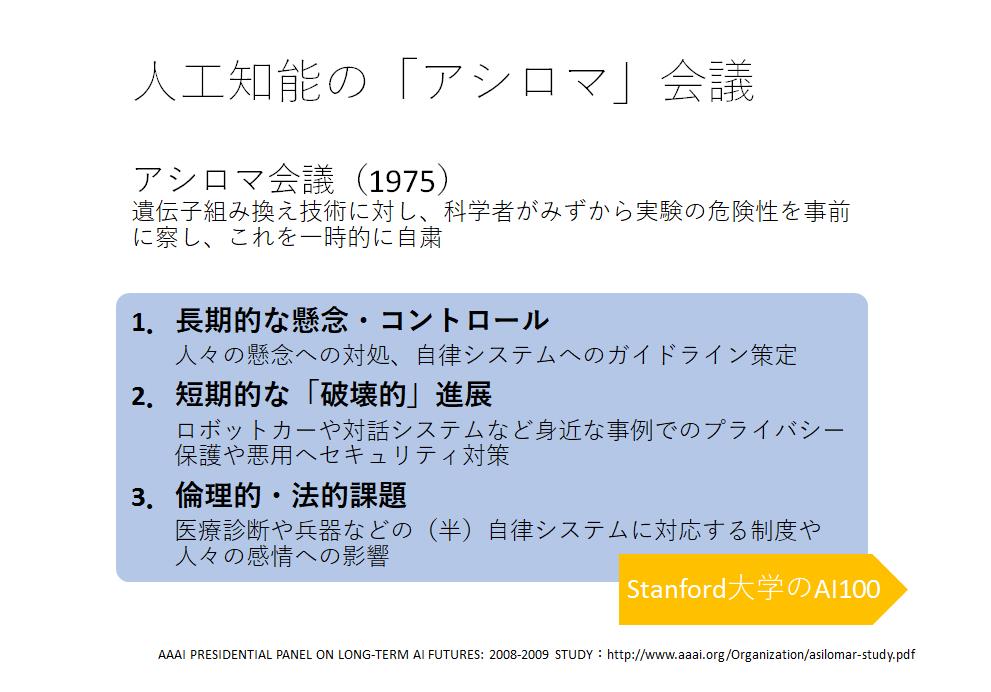

1つはアメリカ人工知能学会(AAAI)が2008年に行ったAAAI Presidential Panel on Long-Term AI Futuresです。なお、この会議に出たことで考えが変わったという感想を述べる研究者もいます。このような集まりでの意見交換を通して、自分たちの研究を見つめなおす機会にもなったとも言えます。

この会議の特徴は、「アシロマ」で行っていることです。1975年に開催されたアシロマ会議は、遺伝子組み換え技術に対する生物学的封じ込めの合意や物理学的封じ込めなどのガイドライン制定の端緒となりました。

人工知能に関しても、研究者自らが、技術の初期段階から危険性に対処していこうとする意気込みからアシロマで開催されたそうです。そこでは、長期的・短期的な課題のほか倫理的・法的な課題についても議論がなされています。ここでの議論はのちに2015年のスタンフォードのOne Hundred Year Study on Artificial Intelligence (AI100)の設立へとつながります。

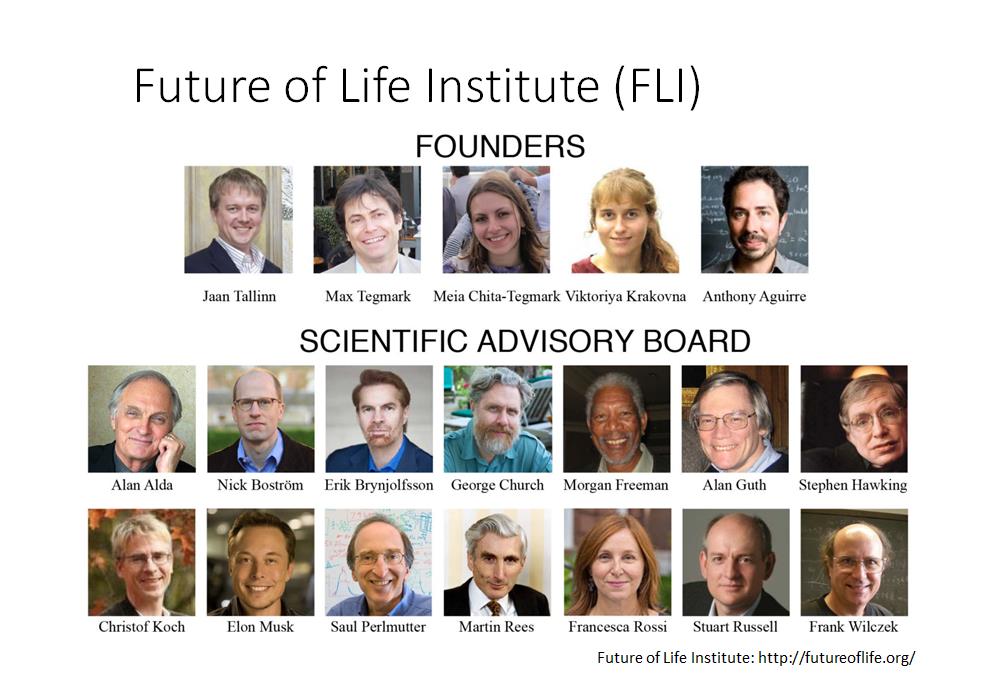

もう一つは、イーロン・マスク氏が1000万ドルを寄付したことで有名なFuture of Life Instituteという非営利団体です。ここでは、人工知能研究者だけではなく、多様な分野の専門家のネットワークが形成されているほか、AIの安全性や危険性に対する研究を支援する助成を行っています。

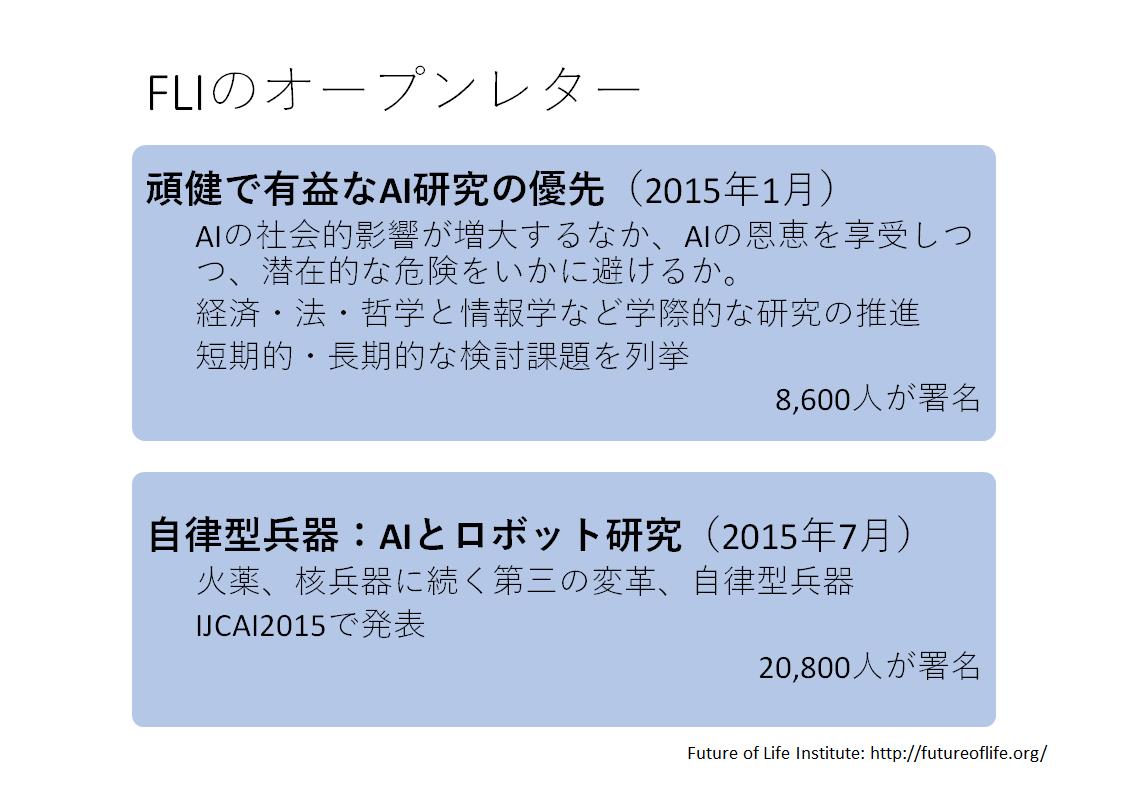

また、定期的にニュースやオープンレターを発信しています。オープンレターは現在までに2つだされています。一つは2015年1月にだされたオープンレターです。人工知能の恩恵を享受しつつも潜在的な危険をいかに避けるかということで、先の「アシロマ」会議などを引き合いに出しながら、長期的・短期的な検討課題を列挙しています。

その後、2015年7月の国際人工知能会議(IJCAI)では自律型兵器に対する懸念についてのオープンレターを発表しています。これらのオープンレターには数千、数万の人々が署名をしています。

このような国内外の政策や社会の動きに対して、日本の人工知能学会倫理委員会はどのようなアプローチをとるのか。倫理綱領という専門家集団としての原理原則を制定する、社会に開かれた対話を行うなど、様々な方向性が考えられます。本報告がこれからの議論のヒントとなればと思います。

- 投稿タグ

- 江間有沙